2026 kan bli året då smarta glasögon blir vardag – och Google är tillbaka

Det var en detalj som fastnade mer än allt annat när jag fick testa Googles kommande Android XR-glasögon: en enkel digital klocka som låg svävande ovanpå verkligheten. Inte en bombastisk 3D-demo eller en futuristisk videoeffekt – utan något så vardagligt som tiden, alltid synlig, alltid där.

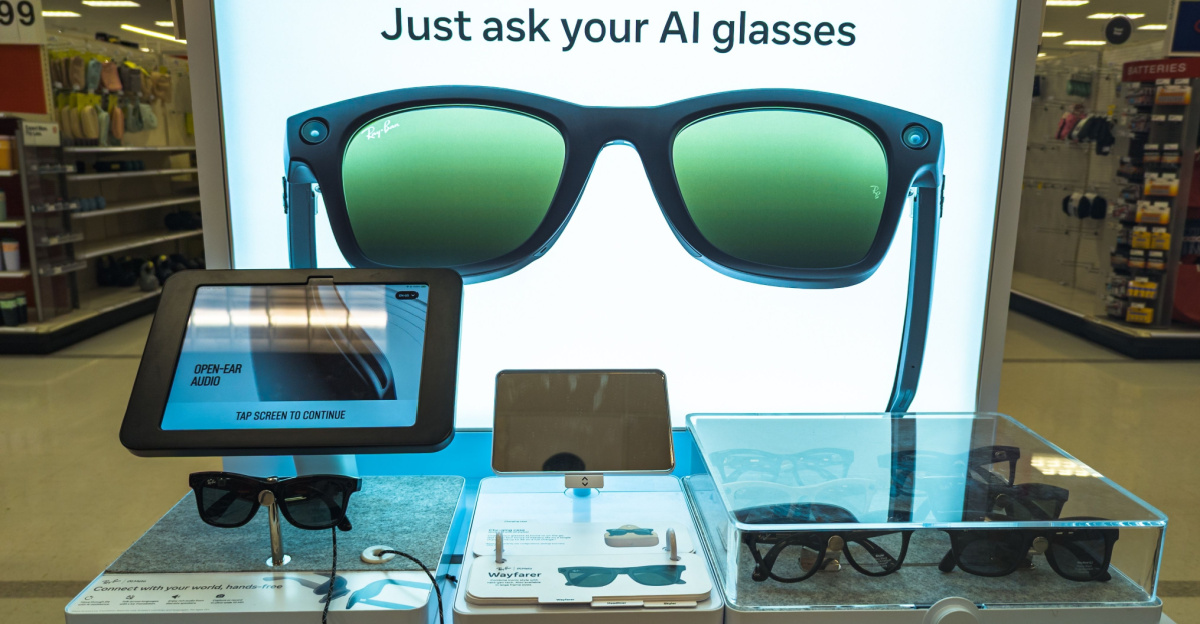

PJ McDonnell / Shutterstock

Och just därför känns det som att Google faktiskt är på väg att göra det man misslyckades med förra gången: att göra smarta glasögon… användbara. På riktigt.

Enligt Bloomberg siktar Google på att släppa sina första AI-glasögon under 2026, i samarbete med bland andra Samsung och modeaktörer som Warby Parker och Gentle Monster.

Först “osynliga” glasögon – sedan skärmen

Googles plan verkar vara stegvis. Först kommer en enklare version utan skärm, men med mikrofoner, högtalare och kamera. Det är glasögon som främst lever på röststyrning och ljud – och som kan användas för allt från kommandon och samtal till att få svar från Googles AI.

Men det är nästa steg som kan bli den stora vändningen: en modell med en liten, enkel bildskärm för ena ögat – så kallad “monokulär” display. Google har själva sagt att en sådan variant är på väg, och att skärmen ska hålla oväntat hög kvalitet, enligt 9to5Google och Android Authority.

Läs också: Nvidia passerade 4 000 miljarder dollar

Det betyder: inte bara ljud i örat – utan information direkt i synfältet.

Meta har lett – men kan ha låst sig i ett hörn

Under tiden har Meta varit det tydligaste namnet på marknaden. Deras Ray-Ban-samarbete har gjort smarta glasögon mer “socialt acceptabla”, men också låst formatet: snygga solglasögon som används utomhus och ofta kopplas till livsstil och träning.

Googles ambition känns bredare.

Android XR-glasögon ska inte vara en accessoar du tar på när solen skiner. Tanken är snarare att de ska fungera som ersättare för vanliga glasögon – något du bär hela tiden, även inomhus. En ny dator i miniformat, bredvid mobilen och kanske till och med klockan.

Läs också: Apple vill köpa F1-rättigheterna

Och det är där skillnaden kan bli avgörande: om glasögonen blir ett permanent vardagsobjekt, då är vi plötsligt i en helt annan produktkategori.

Samsung-effekten – och Android som draghjälp

Det är lätt att underskatta Samsungs roll i det här. När Samsung går in i en hårdvarukategori brukar den snabbt få en helt annan räckvidd. Om glasögonen dessutom kopplas tätt till Android kan de bli en naturlig förlängning av mobilen – ungefär som ett nytt gränssnitt, inte en ny pryl.

Det finns också en strategisk bonus: om funktionerna bara fungerar fullt ut med Android i början kan glasögonen bli ett argument för att välja en Android-mobil. Det är inte osannolikt, eftersom mycket av processningen fortfarande lär ske i telefonen, enligt Googles upplägg kring Android XR, som beskrivs i företagets egna genomgång från I/O, där man visar hur Gemini ska användas i glasögon och headset.

Notiser, ljud – och en framtid där du alltid har “hörlurar” på

Den första vardagliga funktionen är nästan självklar: notiser. Men det finns en intressant bieffekt som kan bli större än man först tror.

Läs också: Samsung fortsätter med galna priser

Om glasögonen alltid sitter på – och har öppna högtalare vid öronen – betyder det att du i praktiken alltid bär ett par hörlurar. Inte in-ear, inte isolerande, utan konstant närvarande.

Det kan förändra hur vi ser på earbuds på sikt. För varför stoppa något i öronen om glasögonen ändå levererar ljud, samtal och assistent?

Kameran som alltid är redo – och allt det obekväma som följer

Sedan har vi den känsligaste punkten: kameran.

Ett par glasögon med kamera innebär i praktiken ett “blickperspektiv” som alltid är redo att filma. Det öppnar för massor av nytta – som att fånga bilder och videor du annars hade missat – men det kommer också med en kulturell och integritetsmässig prislapp.

Läs också: Håll inne knappen – då avslöjar WhatsApp en dold funktion du inte visste fanns

Frågan är inte bara teknisk, utan social: hur reagerar människor när de inte vet om de blir filmade? Det är samma konflikt som Meta redan brottas med – men när Google kliver in i ett större format kan det bli en ännu hetare debatt.

Google kallar det “AI-glasögon” – men är det rätt ord?

Google verkar samtidigt vilja rama in hela formfaktorn som “AI glasses”. Det är logiskt: Gemini blir motorn, och poängen är att du ska kunna få realtidsassistans med hjälp av kameran och kontext från omvärlden.

Det handlar om exakt det som visats i Googles demos av Gemini i XR – en assistent som kan förstå vad du ser och hjälpa dig i stunden.

Men ordvalet är inte riskfritt.

Läs också: Samsung Galaxy Z Fold7: Tunnare, starkare och snabbare

Att kalla något “AI” kan kännas tekniskt, laddat och smalt – särskilt för en bred publik. “Smart”, som i smartphone och smartwatch, är ett ord människor redan accepterat. “AI” kan i stället få vissa att backa. Enligt The Independent är det just Gemini-integrationen som är kärnan, men frågan är hur mycket Google ska trycka på det – och när.

Den stora frågan: varför ska allt ske i ditt synfält?

Till sist återstår en sak som kommer avgöra allt: berättelsen.

Google behöver en tydlig idé om varför saker du redan kan göra på mobilen ska göras framför dina ögon. “Det är coolt” räcker inte, inte längre.

En av de mer intressanta tankarna som lyfts i demos är att glasögonen kan göra dig mer närvarande. Att du snabbt kan titta upp, få information – och sedan gå tillbaka till livet, istället för att fastna i telefonen.

Det låter som marknadsföring, ja. Men det är också en ovanligt mänsklig pitch: mindre skärm, mer verklighet.

Och kanske är det där den där lilla klockan kommer in igen. För om det faktiskt går att få det viktiga – tid, datum, väder, en diskret notis – utan att försvinna in i mobilen… då kan smarta glasögon plötsligt kännas mindre som teknikshow och mer som vardagsverktyg.

2026 kan bli året då det händer. Inte som en nisch. Inte som en gimmick.

Utan som nästa stora formfaktor för konsumentelektronik.